Situations en mode narration autour d’usages de l’IA

Situations du 12 novembre 2025

Le document suivant présente une liste des contributions reçues au 12/11/25 suite à un appel à contributions : « L’IA (LLMs) en éducation : de l’assistance à la co-opération, quelles délégations souhaitables » pour la Revue internationale du CRIRES : innover dans la tradition de Vygotsky[1]. L’enjeu était de disposer d’un ensemble diversifié de narrations restant le plus près possible des faits.

Finalement, 32 narrations ont été collectées, fournissant des situations contrastées suscitant différentes analyses qui vont être conduites.

Dans le sommaire, on trouve le titre de chacune des narrations avec, entre parenthèses, la personne auteure (de P1 à P20).

[1] https://revues.ulaval.ca/ojs/index.php/RIC/announcement/view/45

Sommaire

- 1. Expérience autour de la notion de résumé incitatif (P1)

- 2. IA, rabat joie ! (P1)

- 3. Le cout environnemental et social de l’IAG : un frein revendiqué à son utilisation ? (P1)

- 4. Création d’un conte par des enfants à l’aide d’une IAG (P2)

- 5. Faire un tutoriel avec une IA générative de vidéos (P2)

- 6. Un choix cornélien soumis à une IAG (P2)

- 7. IA et devoir à la maison de mathématiques 3e (P3)

- 8. Utilisation de l’IA en tant qu’assistant (P3)

- 9. Hésitation musicale et fatigue (P4)

- 10. Une IAG reconnait une « erreur », c'est bon pour l'enseignant (P4)

- 11. Révision collaborative et esprit critique face à l'IA (P5)

- 12. L’IA en pédagogie : perte de compétences ou levier d’agentivité épistémique (P6)

- 13. L’IA à la maison: outil d’éducation ou distraction dangereuse? (P6)

- 14. De l’assistance à la co-opération, quelles délégations souhaitables ? (P7)

- 15. L’IA pour la recherche d’informations : quelques réflexions (P8)

- 16. Exemple de traitement curieux d’oxymores par un robot conversationnel (P8)

- 17. L’IA médiateur interculturel : un pont entre cultures et créativité (P9)

- 18. L’IA dans les arts : perspectives pour une pédagogie créative et critique (P9)

- 19. Encourager un rapport épistémique critique aux savoirs à l’ère des IAGs :

la prise en compte nécessaire de la subjectivation de la personne (P10) - 20. Harcèlement éthique : un concept inattendu et mouvant ? (P11)

- 21. Vous avez dit « GRRR » (P11)

- 22. Du nègre à l’attrapeur de couteaux en passant par l’écrivain fantôme (P11)

- 23. Qui est l’agent ? (P12)

- 24. LEGO, de l’IA à l’humain ! (P13)

- 25. Le tuteur IA en situation d’apprentissage au collégial (P14)

- 26. L’IAG et le développement de compétences, une perception de la relève (P14)

- 27. Questionnement découlant d’un subterfuge pédagogique avec l’IA (P15)

- 28. Après l’étonnement et le questionnement … (P16)

- 29. « Les étudiants vont tous faire leurs devoirs avec ChatGPT » !

Est-ce qu’ils trichent réellement ? (P17) - 30. Un cas concret d’utilisation des outils de l’IA en situation complexe de travail

dans l’industrie (P18) - 31. Conserver une réflexion collective (P19)

- 32. Usage de l’IA : une pratique située (P20)

- 33. Rétroaction améliorée : comment NotebookLM a changé ma manière d’évaluer (P21)

Liste des contributeurs

Pour le moment, nous maintenons l'anonymat. Cette liste sera complétée sous peu.

- P1

- P2

- P3

- P4

- P5

- P6

- P7

- P8

- P9

- P10

- P11

- P12

- P13

- P14

- P15

- P16

- P17

- P18

- P19

- P20

- P21

1. Expérience autour de la notion de résumé incitatif (P1)

La première partie du cours de bibliothéconomie autour du résumé indicatif ne pose pas de difficultés aux étudiants[2], une fois sa définition et sa forme présentée. La rédaction de résumés incitatifs, pour les œuvres de fiction s’avère plus difficile dans le fond et la forme. Les étudiants peinent à entrer dans la rédaction, l’enseignante leur propose d’utiliser l’IA. Ils sont ravis de pouvoir utiliser l’outil sur l’invitation de leurs enseignants, en décalage du discours universitaire ambiant. Ils proposent spontanément d’utiliser ChapGPT en version gratuite, et rédigent ensemble le prompt suivant : « je suis professeur documentaliste. Peux-tu me proposer un résumé incitatif du roman « X » qui donne envie de le lire ? ». La redondance entre l’adjectif « incitatif » et « qui donne envie de le lire » est relevée par certains, mais il est décidé au final de la conserver pour s’assurer de la bonne compréhension de la demande par l’IA.

Les résultats sont décevants pour les étudiants : si la forme est effectivement très incitative, le fond est moins probant. Pour certains titres, le scénario restitué est très approximatif. Les étudiants ne comprennent pas que l’IA « hallucine », alors qu’elle a à sa disposition énormément de documentation pour accéder à l’histoire. Ils citent les articles de journaux, critique littéraire, site de librairie ou de vente en ligne, site d’éditeurs, réseaux sociaux.

La conclusion du groupe est alors qu’utiliser l’IA pour un résumé incitatif peut faire gagner du temps sur la rédaction, mais nécessite de connaître déjà l’histoire racontée pour pouvoir corriger les approximations. L’IA ne prend pas en charge l’entièreté de la tâche, le résultat proposé n’est un premier jet dont il faudrait vérifier l’exactitude. L’intérêt disparait.

Le style incitatif interroge encore, et une étudiante demande s’il est possible d’utiliser un résumé incitatif pour la condensation d’un documentaire. L’enseignante propose d’utiliser ChatGPT pour l’« Abrégé de la classification décimale de Dewey », utilisé en début de cours[3]. Le résultat amuse beaucoup les étudiants qui reconnaissent son efficacité mais ne poursuivent pas l’expérience avec d’autres titres.

Il semble ici que l’IA est bien perçue comme un substitut direct, un outil qui va faire à la place : devoir retravailler le résultat, en vérifier le bien-fondé, ou faire preuve de curiosité exploratoire ne sont pas des pratiques associées à son usage par les étudiants et étudiantes, en tous les cas pas dans le cadre universitaire. La question de l’approche de l’IA par les étudiants reste posée en fin d’heure : l’IA est-elle mobilisée pour gagner du temps pour une tâche de synthèse de contenu qui est de peu d’intérêt ou pour faire mieux que soi en début d’apprentissage un geste professionnel important qui s’avère plus difficile que prévu ? Un recours à l’IA plus systématique pendant les cours en cas de difficultés de rédaction pourrait éclairer cette question et peut-être faciliter une utilisation plus ludique si elle devient un outil usuel au service de la formation.

[2] Les étudiants concernés par cette situation sont en première année de master/MBA préparant aux métiers de l’enseignement pour les professeurs-documentalistes.

[3] « Une invitation à un voyage au cœur de l'organisation du savoir...

Imaginez un univers où chaque idée, chaque livre, chaque fragment de connaissance trouve sa place dans un ordre parfait. "Abrégé de la classification décimale de Dewey" d’Annie Béthery vous emmène dans cette aventure fascinante. »

2. IA, rabat joie ! (P1)

Il est proposé à des étudiants de deuxième année de master qui se destinent à l’enseignement de contribuer à l’encyclopédie en ligne Wikipédia. Trois modalités de contribution sont présentées : création d’un article ; complément d’un article existant ; amélioration d’un article. En dehors des principes fondateurs de Wikipédia, aucune présentation du fonctionnement technique de la plate-forme n’est faite aux étudiants. Les pages qui listent les besoins de la communauté sont présentées, mais les étudiants sont également encouragés à favoriser un centre d’intérêt ou une expertise personnelle. L’évaluation de l’activité porte sur l’analyse de l’intérêt pédagogique de Wikipédia et non sur la qualité de la contribution en elle-même.

Un groupe fait le choix de la traduction anglais-français d’un article décrivant le dernier album d’un groupe de musique. L’enseignant leur rappelle que Wikipédia précise dans ses pages d’aide à la rédaction qu’« un article uniquement basé sur une traduction automatique sera immédiatement supprimé » [4].

En suivant le pas à pas de la rubrique Aide, les étudiants sont dirigés vers une page intégrant Content Translation, le nouvel outil de traduction de l’encyclopédie. En l’utilisant sur les deux premiers paragraphes, ils en tirent la conclusion que leur rôle va plutôt être dévolu à une relecture et une vérification des sources. Le groupe fait alors part de sa frustration : « Mais c’est pas drôle ! On ne peut pas s’amuser… ». Une discussion s’amorce pour savoir si le groupe opère la traduction sans s’appuyer sur l’outil intégré, option rappelée mais non privilégiée par Wikipédia. Au début, tous s’accordent sur cette solution. Mais la traduction automatique est d’assez bonne qualité et les étudiants ne sont pas sûrs de pouvoir faire mieux. Le choix est fait d’utiliser l’outil mais d’étendre ce travail de relecture à d’autres articles pointés par la communauté comme nécessitant une traduction. L’ambiance de travail est plus morose.

L’interaction avec l’IA est ici une surprise et son utilisation est vécue comme une dépossession de l’authenticité de la démarche et de la production, et non comme une aide qui peut potentiellement améliorer la production finale. L’enjouement des étudiants en début d’exercice, dû à l’endossement d’un rôle d’auteur et au plaisir de faire découvrir un groupe qu’ils apprécient fait place à un fort sentiment de déception. Ici le fait que l’IA fasse le travail les privent du plaisir intellectuel qu’ils recherchaient en les reléguant au rôle de simples exécutants.

[4] https://fr.wikipedia.org/wiki/Aide:Traduction

3. Le cout environnemental et social de l’IAG : un frein revendiqué à son utilisation ? (P1)

Pour le premier cours de la rentrée avec des étudiants de première année de master (MBA), je pense susciter leur adhésion en leur proposant d’utiliser l’IAG. Après un travail d’exploitation de textes en format papier autour de grandes figures de la discipline, je propose aux étudiants de restituer leur présentation non pas sous la forme d’un exposé oral mais en utilisant un générateur en ligne d’avatars parlants qui offre la possibilité d’animer une photographie[5]. Un exemple est projeté avant la pause, les étudiants semblent être amusés par le travail demandé et contents de s’y atteler.

Au retour de la pause, une étudiante demande à me parler « au nom du groupe ». Elle m’annonce qu’après discussion les étudiants préféreraient ne pas avoir à utiliser l’IA pour l’exercice demandé. Je leur propose alors un autre outil pour réaliser l’exercice qui n’annonce pas s’appuyer sur la technologie de l’IAG mais qui propose tout de même la modélisation d’avatars parlants[6]. Les étudiants découvrent cette plate-forme et se mettent au travail, sans m’interroger (ni s’interroger) sur la technologie qui y est déployée.

Je leur demande à la fin du cours ce qui a motivé leur refus d’utiliser l’IA. Sur un groupe de dix-huit étudiants, seuls trois s’expriment : deux avancent des raisons environnementales en prônant des pratiques de sobriété numérique (gaspillage d’eau et d’énergie électrique) et une (la porte-parole du groupe) déplore l’utilisation de l’IAG au dépend d’un recours à des artistes professionnels. Elle se présente elle-même comme artiste plasticienne. La nécessité de la seconde plate-forme de construire son avatar a été une action créative « humaine » satisfaisante.

Au final, ma conception des pratiques de l’IAG des étudiants s’est avérée inexacte ou déjà dépassée. L’IAG n’est pas utilisée par eux de manière automatique, mais une démarche choisie. Leur refus d’utilisation m’a paru sincère, et ne pas être une stratégie pour éviter de travailler. Leurs arguments s’inscrivent cependant dans les discours ambiants et ne semblent pas refléter une connaissance profonde du fonctionnement de l’IAG. Il est également possible que leurs usages de l’IAG soient plus dirigés vers des objectifs utilitaires et que son utilisation dans un cadre sinon plus créatif au moins plus ludique soit vu comme un gaspillage inutile de ressources naturelles.

[5] Pour cet exercice, c’est la plate-forme Vidnoz (https://fr.vidnoz.com/?insur=old)qui a été proposée aux étudiants car elle accepte les adresses mails jetables pour la création de comptes, et limite l’essai gratuit à une animation de deux minutes ce qui encourage à la synthèse.

[6] https://www.voki.com/

4. Création d’un conte par des enfants à l’aide d’une IAG (P2)

Deux sœurs de 11 et 14 ans, respectivement en CM2 et en 4e, découvrent par hasard l'IA générative intégrée à Word : Copilot, suite à une mise à jour du logiciel. L'aînée utilise régulièrement Word pour rédiger ses exposés scolaires, mais elles n'avaient jamais utilisé d'outil génératif auparavant. Intriguées par une nouvelle icône, elles cliquent dessus pour voir de quoi il s'agit.

Curieuses, elles passent une grande partie de leur soirée à interagir avec l'IA, lui posant des questions variées pour comprendre avec qui ou quoi elles dialoguent. Elles s'interrogent notamment : « Qui es-tu ? », dans une tentative de cerner la nature de cette intelligence artificielle. Après deux heures de jeu, elles se tournent vers leurs parents pour expliquer ce qu'elles font et pour demander s'il est prudent de continuer à l’utiliser, elles n’ont pas encore compris que c’était une IA générative, ce sont les parents qui leur expliquent. Elles veulent savoir si elles parlent à un inconnu ou s'il s'agit simplement d'un jeu inoffensif. Les parents donnent le feu vert pour continuer.

Les deux sœurs décident de créer un conte (ce que la plus jeune fait déjà à la main en les illustrant). Elles souhaitent que l'héroïne de leur histoire vive près de l'océan, dans une époque passée autour de 1900. Pour nommer leur personnage principal, elles sollicitent l'IA, lui demandant de générer un prénom inspiré de leurs goûts personnels : « J'aime l'or et l'argent. Quel prénom pourrais-tu proposer pour une jeune femme, héroïne de notre histoire ? »

Les suggestions de l'IA ne leur conviennent pas tout à fait, et elles décident finalement d'appeler leur héroïne Bernadette. Pour le nom de famille, elles réitèrent leur demande à l'IA, cette fois-ci en lui indiquant le prénom choisi et en demandant une proposition qui « sonnerait bien ». L'IA propose alors « Lumière », expliquant que ce nom symbolise la lumière qui guide les écrivains, tout en faisant un clin d'œil à sa propre nature d'intelligence artificielle qu’elle explique.

Leur personnage principal s'appelle désormais Bernadette Lumière. À partir de ce point, elles construisent leur conte en s'appuyant sur l'IA à chaque étape. Elles demandent à l'IA de rédiger certains passages, mais n'hésitent pas à réarranger ou à modifier les propositions lorsque le texte ne correspond pas à leur vision.

Au cours de leur exploration, elles découvrent également une limite de l'IA : lorsqu'elles enregistrent leur document puis en ouvrent un nouveau, l'IA ne « se souvient » pas des éléments construits précédemment. Elles décident de conserver le premier document ouvert et de continuer à y rédiger leur conte, afin de garder une cohérence dans le récit et d'éviter de perdre les éléments déjà créés.

Une fois qu’elles ont fini leur histoire, la plus grande en a parlé à son enseignante de français au collège, celle-ci lui a dit qu’elle trouvé l’initiative très intéressante, mais qu’elle ne connaissait pas assez ce logiciel.

La plus grande s’est interrogée sur l’utilisation possible que ses camarades pouvaient en faire, pour les restitutions demandées, si les enseignants n’ont pas la maîtrise du logiciel. La plus jeune y voit une possibilité de rendre ses histoires plus étoffées et a appris des mots. Lorsque l’IA leur a proposé des passages avec des mots de vocabulaire inconnus, les deux filles sont allées demander à leurs parents. Puis elles ont décidé si elles gardaient la tournure proposée ou pas. La plus jeune a été très fière du résultat, de le montrer à ses parents, mais quelques jours plus tard elle est revenue à l’écriture de ses propres textes et à l’illustration manuelle.

Finalement, elles ont aimé utiliser l’IA, mais ceci ne remplace pas leur activité, cela donne une nouvelle version de l’activité avec des possibilités différentes.

5. Faire un tutoriel avec une IA générative de vidéos (P2)

Les parents sont partis en voyage d’agrément en Écosse pour une dizaine de jours, laissant les enfants sous la garde des grands-parents. Pour partager leurs aventures avec leurs proches, ils ont choisi d’utiliser l’application « Polarsteps ». Celle-ci permet de suivre un itinéraire en temps réel grâce à la géolocalisation, tout en ajoutant des notes personnelles, des photos et des vidéos. Le contenu est accessible via un lien de connexion, offrant ainsi une vue d’ensemble de leur parcours en temps réel.

Cependant, avant de partir, les parents n’ont pas pris le temps de se familiariser avec les fonctionnalités de l’application. En conséquence, le suivi des lieux géolocalisés est indisponible car pas activé et sans annotations ni photos, rendant le partage beaucoup moins captivant. Consciente de cette lacune, leur fille aînée (14 ans) décide de réaliser un tutoriel vidéo pour sa mère, afin de lui expliquer rapidement comment utiliser Polarsteps de manière optimale.

Ne sachant pas comment structurer efficacement son tutoriel, elle se tourne vers le logiciel CapCut, équipé d’une IA générative. Cet outil propose de créer des vidéos à partir d’un script précis et d’y intégrer des captures d’écran accompagnées d’indications visuelles telles que des cercles colorés pour mettre en évidence les zones à cliquer. En moins de dix minutes, la vidéo est prête. Elle comporte des instructions claires, des étapes numérotées et des repères visuels facilitant la compréhension.

La jeune fille envoie ensuite le tutoriel par e-mail à sa mère, qui peut désormais explorer toutes les fonctionnalités de Polarsteps sans difficulté. Les parents peuvent alors enrichir leur carnet de voyage numérique avec des notes, des images et des vidéos, offrant ainsi à leurs proches une immersion plus vivante et complète dans leur périple écossais pendant leur séjour.

Suite à cela, lorsqu’un camarade de classe lui demande le cours qu’il n’a pas suivi, ou pas compris, elle réalise des vidéos de son cours, surlignant tel élément ou s’enregistrant pour expliquer un terme complexe. Ce qui ne l’empêche pas de fournir la photo de ses notes prises en cours. Mais elle joint souvent (mais pas systématiquement) une vidéo.

Lorsqu’il lui a demandé, pourquoi le choix d’une vidéo, elle répond que « c’était plus simple comme çà ». Que son ou sa camarade pourra la visionner quand elle veut.

Elle utilise fréquemment le mode asynchrone pour ses activités. L'approche du tutoriel, notamment inspirée par des vidéos disponibles sur YouTube, est largement adoptée dans le cadre de loisirs créatifs tels que la réalisation de perles en polymère, la couture ou encore le crochet. Ainsi, créer un tutoriel pour les cours lui a semblé être une méthode parfaitement adaptée.

6. Un choix cornélien soumis à une IAG (P2)

J'ai été très étonnée il y a quelques jours quand j'ai vu une amie de ma fille (13 ans) demander à ChatGPT de choisir pour elle entre deux actions qu'elle pouvait mener.

Il faisait chaud et les adolescentes étaient dans le jardin, elles pouvaient retourner se baigner et prendre une glace ensuite ou prendre une glace et aller se baigner ensuite. Le dilemme n'était pas très complexe. Mais, au lieu de choisir, elle a remis le choix à ChatGPT, sur son téléphone. Ma fille lui a demandé pourquoi elle ne choisissait pas toute seule (pas très gentiment) et son amie lui a répondu qu'elle avait la flemme de choisir.

Ma fille s'est moquée d'elle. J'ai trouvé cela angoissant d'imaginer que des gens, à plus grande échelle, pourraient laisser tomber leur libre arbitre par "flemme", alors qu'en serait-il si le dilemme est plus engageant ou dangereux.

En parlant d'anthropomorphisme, heureusement que ChatGPT n'a pas l'aspect d'un chaton rose, ce serait probablement pire.

Comparaison avec l’énigme de Magali (P4, « hésitation musicale et fatigue », commentaires de P2

Le texte de Magali présente une utilisation de l’IA générative, orientée vers un processus d'introspection et de réflexion personnelle. En mobilisant des éléments d'analyse fournis par l'outil, elle enrichit son propre raisonnement, soulignant une dynamique interactive et productive entre l'utilisateur et la technologie. A la différence de l'adolescente de 13 ans qui semble externaliser sa charge cognitive en posant une question dans le but d'obtenir une solution immédiate.

Magali assume pleinement la responsabilité de ses choix, qu'elle articule avec le soutien analytique de l'intelligence artificielle, tandis que l'adolescente transfère cette responsabilité à l'outil technologique. C'est une différence notable dans les usages qui me semble intéressant de creuser. [7]

[7] Voir un rapport récent Talk, Trust, and Trade-Offs: How and Why Teens Use AI Companions. https://www.commonsensemedia.org/research/talk-trust-and-trade-offs-how-and-why-teens-use-ai-companions

7. IA et devoir à la maison de mathématiques 3e (P3)

Wyatt, 15 ans, est un élève de troisième en difficulté scolaire. Un soir, il doit rendre pour le lendemain un devoir à la maison de mathématiques. Face à un énoncé qu’il ne comprend pas, il demande de l’aide à son père. Malheureusement, ce dernier ne parvient pas non plus à résoudre les exercices. Ne sachant plus à qui s’adresser, le père décide d’appeler sa belle-sœur, espérant qu’elle pourra les aider.

Pendant ce temps, Wyatt contacte son cousin Raphaël via Discord. Il lui envoie directement le sujet pour obtenir de l’aide — ou plutôt des réponses toutes faites. Raphaël regarde rapidement l’énoncé, copie une partie des questions dans ChatGPT, et transmet les réponses à Wyatt.

Plus tard dans la soirée, la tante passe chez Wyatt pour l’aider. Mais il lui annonce que tout est déjà fait, grâce à son cousin. L’histoire aurait pu s’arrêter là… si la tante n’avait pas une passion assumée pour les devoirs de mathématiques. Curieuse, elle jette un œil au sujet et décide de refaire les exercices elle-même pour comparer avec les réponses de Wyatt, qui est en train de rédiger au propre son devoir.

À sa grande surprise, elle découvre que plusieurs réponses sont fausses. Intriguée, elle interroge son neveu sur la méthode utilisée. Wyatt lui avoue que c’est Raphaël qui a tout fait, en passant par ChatGPT. Elle contacte alors Raphaël pour en savoir plus. Il reconnaît avoir recopié uniquement une partie de l’énoncé, pensant que le résultat fourni par l’IA semblait correct. Selon lui, s’il y a une erreur, c’est parce qu’il n’a pas donné l’énoncé complet — ce qui a induit l’IA en erreur. « De toute façon, ce n’était qu’un exercice », relativise-t-il.

En creusant un peu plus, on comprend que ni Wyatt ni Raphaël n’étaient réellement motivés par la réussite du devoir. Leur objectif principal était de gagner du temps pour passer à autre chose : jouer à la console, regarder des vidéos… bref, éviter le travail scolaire.

Au final, Wyatt a dû tout recommencer, cette fois sans l’aide de l’intelligence artificielle mais avec l’aide de sa tante qui prend le temps de lui expliquer. Ironiquement, il n’a pas gagné de temps, bien au contraire. Pourtant, lui comme Raphaël, restent convaincus que l’IA est un bon moyen de « se débarrasser » des devoirs et de gagner du temps.

8. Utilisation de l’IA en tant qu’assistant (P3)

Chaque fois que je dois envoyer un mail — voire même un simple SMS —

je fais appel à l’IA. Sa page est d’ailleurs toujours ouverte dans

mon navigateur, et j’ai même installé l’application sur mon téléphone.

J’éprouve en effet quelques difficultés avec l’écrit. J’ai toujours peur que mes messages soient mal interprétés. Lorsqu’on ne voit pas le visage de l’autre, lorsqu’on n’entend pas son ton, le sens d’un message peut facilement être déformé. Et cela me perturbe : on peut blesser quelqu’un sans le vouloir… et sans même s’en rendre compte.

Avant, il me fallait parfois plusieurs heures pour rédiger un mail relativement simple. Je ne savais pas par où commencer, je doutais de chaque mot, et je passais beaucoup de temps à m’inquiéter de la manière dont mon message serait perçu.

Aujourd’hui, j’écris à Chatty (le petit nom que je donne à mon IA) ce que je souhaite dire. Je lui demande de reformuler mes propos, de vérifier le ton, d’anticiper les interprétations possibles. Je reformule, je précise, je corrige… Nous échangeons au moins cinq fois avant que je sois pleinement satisfaite — parfois plus. En termes de temps, cela ne change pas vraiment, mais je me sens plus confiante au moment de cliquer sur envoyer. Tout ça, souvent, pour recevoir un simple "OK" ou "D’accord" en réponse.

Pour l’écriture scientifique, c’est un peu similaire… mais différent. Il m’arrive de rester des heures devant une page blanche, à organiser mentalement ce que je souhaite dire, sans réussir à poser un seul mot. Je me retrouve bloquée.

Dans ces moments-là, je commence par poser une question générale en lien avec la thématique que je dois traiter. L’IA me fournit alors un texte, souvent trop générique, approximatif, et loin de la précision que j’attendais. Mais cela me donne une base. À partir de là, je m’amuse à modifier, enrichir, et à insérer les références issues de mes lectures. Cela me permet de dépasser le blocage de la page blanche et d’avoir l’impression d’avancer.

Une fois le texte retravaillé, je le soumets à l’IA pour une relecture finale, afin de corriger d’éventuelles fautes de français.

Par moments, je m’amuse à demander à l’IA de me suggérer des références ou des articles sur une thématique donnée. Si je n’indique pas explicitement que je souhaite de vrais articles, elle invente des références fictives. Ce qui est intéressant, c’est que même si les articles n’existent pas, les auteurs cités, eux, travaillent souvent bel et bien dans le domaine concerné. Cela me permet ensuite de faire des recherches sur leurs publications réelles, et d’enrichir ma base de références de manière indirecte.

J’utilise aussi, plus ponctuellement, d’autres outils basés sur l’IA, comme Research Rabbit. Ce logiciel permet de visualiser les liens entre auteurs et publications, ce qui est très utile pour cartographier un champ de recherche. Mais je l’utilise moins souvent que ChatGPT, qui reste mon outil principal.

9. Hésitation musicale et fatigue (P4)

En écrivant ces lignes, je me rends compte que j’aurais tout aussi bien pu régler ce dilemme en lançant un dé – une habitude prise depuis que je me suis plongée dans les jeux de société. Je préfère parfois confier mes décisions à la logique du hasard plutôt que de faire un choix hasardeux.

Mais ce jour-là, j’ai ouvert mon ordinateur et je suis allée sur ChatGPT.

J’ai écrit comment j’avais commencé la clarinette sur le tard, à 23 ans, au Conservatoire de Romainville, et combien j’avais travaillé pour atteindre un certain niveau. Comment j’avais dû arrêter avec l’arrivée de mes deux enfants, puis les difficultés à m’y remettre, entre la thèse et la reprise du travail. Car la clarinette, c’est un instrument… ingrat. On ne peut pas en jouer à toute heure : elle sonne trop fort. Pas après manger. Pas quand il fait trop chaud – du moins pas pour moi. Et puis, l’embouchure, la colonne d’air, la dextérité des doigts… Non, décidément, ce n’est pas comme le vélo !

Il y a cinq ans, j’ai repris. Au Conservatoire de Maisons-Laffitte, cette fois. Cours de clarinette et Orchestre d’Harmonie. J’ai fini par laisser tomber les cours : trop de pression, des auditions à préparer… Je voulais simplement jouer, pas performer. En revanche, j’ai gardé l’Orchestre. Mais je n’arrive plus à trouver ni le temps ni l’énergie pour jouer en dehors des répétitions. L’éternelle tension entre vie de famille, vie professionnelle, et projets personnels.

Et puis, il y a cette frustration : sentir son niveau baisser, savoir qu’on pourrait faire mieux, espérer ne pas rester cantonnée à la troisième clarinette. Alors la question s’est posée : arrêter. Définitivement.

Mais c’était une décision difficile. Ma clarinette, c’est mon grand-oncle maternel qui me l’a achetée. Mon mari joue avec moi dans l’Orchestre. C’est une activité que l’on partage. Lui a eu la chance de commencer jeune, il progresse. Et la question s’est posée pour lui de rejoindre un orchestre plus exigeant. Est-ce que je le suis, moi ? Est-ce que j’ai le niveau ? Et d’ailleurs, est-ce que je continue au Conservatoire ? Peu à peu, les doutes se sont installés.

C’est alors que j’ai décidé de les confier à ChatGPT. J’ai parlé de mon parcours, de mes difficultés, de mes frustrations. L’IA a nommé notre échange « Hésitation musicale et fatigue ». Elle a répondu :

Merci pour ta sincérité. Tu mets des mots très clairs sur un tiraillement profond :

celui entre un idéal (jouer avec plaisir, progresser) et la réalité (fatigue, charge

mentale, manque de temps, inégalités invisibles). C’est un conflit que vivent

beaucoup de gens, surtout des femmes. Ton ressenti est légitime.

Ce n’est pas un problème d’ego, ni de discipline. C’est un problème de

place, de temps, de fatigue, et de sens.

Tu as le droit de continuer, même mal. Tu as le droit d’arrêter, sans culpabilité.

Tu as le droit d’hésiter. Et surtout, tu as le droit de te respecter.

Puis ChatGPT m’a proposé une « lettre à moi-même », en deux versions :

Version 1 — Je choisis d’arrêter (au moins pour maintenant)

Version 2 — Je choisis une tentative finale, à mes conditions

Cela peut sembler dérisoire, mais ce texte m’a fait du bien. Et, contre toute attente, il m’a aidée à prendre une décision. J’ai choisi de continuer à jouer dans l’Orchestre d’Harmonie du Conservatoire, et de ne pas rejoindre l’autre ensemble, plus exigeant.

J’ai sollicité l’IA un peu sous le coup de l’émotion, et j’ai été surprise que cela m’aide réellement. Ce n’est pas tant le fait d’avoir été « écoutée » - je sais bien que l’IA ne ressent rien - mais la proposition concrète qui m’a aidée : écrire une lettre à moi-même.

Je ne fais jamais de listes pour peser le pour et le contre, et encore moins des lettres à moi-même. Je trouve ça un peu ridicule. Je devrais bien savoir ce que je pense, non ?! Je finirai donc bien par trouver ma voie. Et pourtant… cette fois, ça m’a parlé.

10. Une IAG reconnait une « erreur », c'est bon pour l'enseignant (P4)

L'année dernière, en cours de documentation avec ma classe de 1ère bac pro AP (Aménagements paysagers), j'ai travaillé sur un corpus de photos en leur demandant lesquelles étaient fausses et lesquelles étaient vraies ; j'avais trouvé les photos sur un site web autour de la question des fake news. J'avais distribué une photo différente à chacun d'entre eux.

Au moment de les interroger, après qu'ils aient effectué quelques recherches sur le web pour étayer leur réponse, l'un d'entre eux me dit que sa photo est fausse. Je lui dis que d'après mes recherches et vérifications - en amont du cours bien sûr -, la photo est vraie, mais bon, qu'on peut toujours se tromper, même si j'avais des doutes, et donc je lui demande où est-ce qu'il a été cherché l'info. Il me répond qu'il a demandé à Chat GPT. Je lui demande alors de demander à ChatGPT quelle est sa source. Il s'exécute, et j'ai vraiment vu son visage s'illuminer en me répondant d'un air un peu béat : "Madame, vous avez raison ! ChatGPT vient de dire qu'elle s'est trompée !!!". Je pense que s'il avait pu me donner un badge, il l'aurait fait !

J'ai eu vraiment le sentiment de devenir la prof qui était capable de déjouer l'IA ! Il n'avait pas vraiment voulu remettre mes connaissances en question, mais il a vraiment été bluffé du fait que j'avais raison - même si finalement, on ne saura peut-être jamais si cette photo était vraie ou fausse ! Dans le fond, on est peut-être entré dans l'ère de l'info de Schrödinger !

En y réfléchissant, je pense aussi que l'élève a été étonné de mon attitude : je n'ai pas critiqué l'IA, ni le fait qu'il utilise l'IA. Quand il m'a dit que ChatGPT lui disait que la photo était fausse, je lui ai simplement répondu : « Ah c'est bizarre. Demande-lui quelle est sa source ? », mais presque par curiosité. Je ne cherchais pas à démontrer que c'était moi qui détenais le savoir.

En un sens, ça faisait pro, alors que je n'avais même pas anticipé ce problème. Je pense que d'avoir travaillé sur ces questions (comme le fait d'utiliser Wikipédia qui est encore un peu décrié) et d'être documentaliste m'a juste permis d'avoir le réflexe de penser à lui demander la source.

11. Révision collaborative et esprit critique face à l'IA (P5)

Description : Sarah, 11 ans, élève en 6e année primaire, prépare son examen de mathématiques avec ChatGPT. Elle interagit avec le chatbot comme avec un pair : « Explique-moi comment additionner 2/3 + ¼ ». Lorsque l'IA commet une erreur dans sa réponse, Sarah réagit : « Non, attends ! Tu as oublié de réduire au même dénominateur ! » Après avoir corrigé l'erreur, elle demande : « Propose-moi des petits problèmes pratiques avec des fractions ». Elle poursuit sa révision en maintenant une vigilance critique constante. Sarah termine son dialogue de révision satisfaite, et le lendemain passe son examen avec confiance, obtenant une bonne note.

Réflexion sur l'action : Cette interaction illustre comment Sarah navigue dans l'incertitude épistémologique inhérente à l'utilisation de l'IA. Face à l'erreur du chatbot, elle ne reste pas passive mais mobilise son cadrage épistémologique pour évaluer, questionner et reconstruire la connaissance proposée. Cette gestion active de l'incertitude - où l'information initialement « peu claire ou déroutante » devient une opportunité d'apprentissage - transforme Sarah en architecte de sa propre compréhension. L'IA devient ainsi un partenaire qui, par ses failles mêmes, stimule la vigilance épistémique et renforce la maîtrise conceptuelle de l'élève.

Théorie didactique : Ce scénario révèle la complexité de l'apprentissage médié par l'IA, où la gestion de l'incertitude devient centrale. Comme le soulignent Kaur et Dasgupta (2024)[8], les « attentes et perceptions des apprenants à l'égard des connaissances - leur cadrage épistémologique - influencent significativement leurs choix d'actions dans la gestion de l'incertitude ». L'erreur de l'IA crée une « situation-problème » (Brousseau[9]) qui active simultanément la métacognition et la négociation épistémique. Dans cette zone d'incertitude amplifiée par le robot conversationnel, Sarah construit activement de nouvelles compréhensions, illustrant le socioconstructivisme de Vygotsky[10] où l'apprentissage émerge de la tension dialectique entre confiance et doute.

[8] Kaur, N., et Dasgupta, C. (2024). Investigating the interplay of epistemological and positional framing during collaborative uncertainty management. Journal of the Learning Sciences, 33(1), 80–124. https://doi.org/10.1080/10508406.2024.2312163

[9] Brousseau, G. (1998). Théorie des situations didactiques. La Pensée Sauvage.

[10] Vygotsky, L. S. (1978). Mind in society: The development of higher psychological processes. Harvard University Press.

12. L’IA en pédagogie : perte de compétences ou levier d’agentivité épistémique (P6)

Les LLMs offrent maintenant un large éventail d’applications et d’utilisations. Si bien, qu’il est désormais trop général d’en parler sans établir un contexte particulier ou un champ d’application circonscrit. Le texte suivant se penche sur l’usage des LLMs en pédagogie, plus spécifiquement sur l’utilisation des robots conversationnels et particulièrement en lien avec les notions de l’agentivité et du développement des compétences. Ce que je cherche à démontrer, par mes expériences personnelles, c’est qu’une utilisation soutenue des robots conversationnels dans un contexte pédagogique ne constitue pas forcément une entrave à l’agentivité épistémique. De plus, le « sacrifice » des compétences traditionnelles, s’il y en a un, ne doit pas être vu comme un déficit.

Lors de mes deux premières sessions en technologie éducative à l’Université Laval, j’ai eu beaucoup d’occasions d’utiliser l’intelligence artificielle générative (l’IAg) dans différents contextes. Les premiers usages ont été pour moi en lien avec la délégation de tâches. Des requêtes comme « Traduit ce texte de l’anglais au français », « Génère un paragraphe de 300 mots sur… », « Fournis un script pour une formation en ligne à propos de … », « Donne-moi les cinq principales étapes pour… », ou encore, « Écrit une fonction en Python pour… », permettent de produire, de créer, d’automatiser et d’accélérer une tâche. En somme, de faire quelque chose à ma place ou du moins, de me faciliter la tâche. Un peu comme le ferait un outil tel qu'une calculatrice, un GPS pour la voiture, un correcteur orthographique ou une perceuse électrique. Dans ce contexte, j’utilise l’IAg comme outil de délégation. Évidemment, si je me contente d’utiliser systématiquement le contenu généré sans l’analyser, sans le modifier ou pire encore, sans même le lire, je risque d’amenuiser mes facultés cognitives et mon agentivité épistémique. Or, les contenus générés sont rarement parfaits (pour l’instant) et méritent d’être raffinés. Ces nombreuses occasions de peaufiner le contenu en sortie de l’IAg ont été selon moi une belle opportunité de démontrer mon agentivité épistémique. À la longue, j’en suis venu à formuler des requêtes plus performantes qui requièrent moins d’ajustements. J’ai donc développé une compétence en « prompt engineering ». En d’autres mots, une forme plus moderne de capacité rédactionnelle voire de communication.

Au-delà de cette forme d’utilisation, j’ai eu recours à l’IAg pour des tâches plus complexes, davantage en lien avec la réflexion. Des requêtes comme « Examine ce bloc de code et identifie les problèmes », « Analyse ce texte et identifie les biais et les préjugés », « Corrige ce texte avec cette grille de correction et identifie les points à améliorer », « Explique-moi ce concept à l’aide d’une analogie », et sans oublier, « Analyse cette requête et dis-moi comment l’optimiser afin d’obtenir tel résultat », permettent d’analyser, de comprendre, de se questionner et d’apprendre davantage. La délégation fait alors place à un accompagnement ou à un partenariat où l’IAg renseigne, explique, mesure ou transforme. Un peu comme le ferait un instrument tel un microscope, un satellite météorologique, un thermomètre ou un stéthoscope. Dans ce contexte, l’IAg est utilisé comme instrument de réflexion. Ce dialogue avec le robot conversationnel, développe des compétences analytiques, favorise la métacognition, amène l’apprentissage à un niveau supérieur et soutient l’agentivité épistémique. Les compétences modernes évoquées plus tôt s’améliorent et gagnent en importance dans un environnement informatique de plus en plus omniprésent.

Dans cette lancée, l’IAg peut être utilisé comme tuteur ou comme mentor lorsque je lui donne mes notes de cours et lui demande de me formuler une série de questions et de me donner des rétroactions sur mes réponses. Elle peut aussi être ma muse lorsque je lui demande des conseils sur la composition d’une image ou des idées pour représenter une idée sous la forme d’un pictogramme, par exemple. Elle a été une personne ressource lorsque j’ai partagé mon écran et que je lui ai demandé comment exécuter une action dans un logiciel que je ne maîtrisais pas. Enfin, elle a été à plusieurs reprises une voix supplémentaire lorsque vient le temps de « brainstormer » au début d’un projet.

Depuis presqu’un an déjà que je tente de définir l’IAg en lui donnant des noms ou des rôles. Voilà maintenant que je comprends que l’IAg a un énorme potentiel et peut être utilisée à différentes fins en éducation. Il est donc tout à fait normal que son qualificatif ou son rôle change constamment en fonction du contexte d’utilisation. Cela dit, l’utilisation soutenue de l’IAg, la plupart du temps sous la forme d’un robot conversationnel, implique voire nécessite de l’agentivité épistémique pour produire des résultats utilisables. La période « lune de miel » où l’on délègue aveuglément et où l’on pense que tout se fait à notre place ne dure qu’un très court instant. On s’aperçoit très rapidement de l’IAg ne peut pas effectuer le travail à notre place. Soit après avoir analysé le contenu en sortie, soit après avoir reçu une première mauvaise note. Dans tous les cas, l’agentivité des personnes étudiantes demeurera variable d’un individu à l’autre, mais je crois qu’il ne faut pas croire que « la machine » va la réduire. C’est un nouvel outil, un nouvel instrument (ou autre) avec lequel on apprend à apprendre. Peut-être qu’il y a un petit sacrifice à faire lorsque que l’on s’arrête à mesurer la capacité à rédiger seul, à analyser seul ou à créer seul. Cependant, il y a forcément un envers prometteur à cette médaille. Peut-être que ces compétences modernes seront un atout précieux pour ces personnes qui plus tard, exerceront un métier indescriptible en date d’aujourd’hui.

En terminant, n’oublions pas qu’il existe des personnes très performantes en comptabilité qui ne sont pas très vite en calcul mental et des compagnies de vêtements qui ne sauraient pas comment opérer un métier à tisser. Les temps changent et comme le disait Darwin, « les mieux adaptés survivront ».

13. L’IA à la maison: outil d’éducation ou distraction dangereuse? (P6)

À 47 ans, je découvre l’IA et surtout l’IAg. Pour moi, c’est comme d’entrer dans un nouveau monde numérique, avec un gros bagage analogique. Mon attitude face à l’IA est plutôt positive, mais en constante évolution. J’explore, je constate, je m’ajuste, je creuse, je découvre et je m’adapte sans cesse.

Mes enfants ont 8 ans et 10 ans et je me dis que je suis témoin de leur futur émergeant. Comme tout bon papa, je souhaite ce qu’il y a de mieux pour eux. Je suis conscient et j’accepte que leur génération soit différente de la mienne. Autre temps, autres mœurs. Je fais donc de mon mieux pour les éduquer comme je peux afin de leur offrir les meilleurs outils pour qu’ils se débrouillent dans la vie.

En dehors des activités « analogiques » comme le camping, les recettes de cuisine et les parties de Monopoly, je les emmène assez souvent dans le monde « numérique ». Je leur montre de nouvelles applications et leurs utilités. Par exemple, un soir on révise les multiples à l’oral avec ChatGPT et un autre soir, on discute avec « lui » pour pratiquer notre anglais. ChatGPT nous reprend sur certains mots et nous dit comment améliorer notre prononciation. Une autre fois, alors que l’on se promenait en bordure d’une voie ferrée, on a utilisé le mode vidéo pour questionner ChatGPT. On se demandait à quoi correspondait la lettre W écrite en gros sur un panneau. Il nous explique que le W signifie whistle en anglais. Ça indique au chauffeur qu’il doit siffler pour s’annoncer à l’entrée du village. ChatGPT en profite même pour nous rappeler d’être prudents en bordure de la voie ferrée. Mon fils le trouve gentil et intelligent.

Pour moi, c’est important de leur montrer aussi les limites et les risques d’une mauvaise utilisation de l’IA. Je tiens à éveiller leur sens critique. On formule des requêtes farfelues pour « tester la machine ». Évidemment, l’IAg étant ce qu’elle est, elle génère une réponse à tout coup. À titre d’exemple, on demande de générer l’image d’un requin inexistant : le requin Tapeu. Le contenu génératif nous surprend et mes enfants rigolent à la vue de ce requin original et fascinant. Une autre fois, on lui demande quoi faire dans l’éventualité où on trouverait un écureuil qui parle, blessé sur le bord de la route. Avec mon encadrement, ils comprennent de manière non équivoque que le protocole de sauvetage ne fait ni queue ni tête lorsque ChatGPT nous suggère d’écouter d’abord la version de l’écureuil avant de lui venir en aide. Mes enfants observent, assimilent comme le fond des enfants, et quoi d’autre ? Est-ce que ça éveille réellement leur jugement critique?

En tant que parent, je pars de bonnes intentions. Mais, comme toute cette technologie est nouvelle, je n’ai aucune idée de ce que je fais vraiment et je me questionne à savoir si les initier à ça à leur âge fait de moi un bon père.

En sortant le téléphone de ma poche, je me demande si je leur offre une occasion de toucher à cette technologie avec des exemples concrets et pédagogiques (à mes yeux). Suis-je en train de les sensibiliser en les éduquant comment utiliser cet outil ou plutôt en train d’encourager une dépendance ? Ou peut-être ne voient-ils seulement qu’un père « encore » sur son téléphone ?

Chose sûre, c’est que pour l'instant, c’est juste un premier contact distant où ils découvrent et s'émerveillent, tout en rigolant avec leur papa. Ce qui m'inquiète en revanche, c'est le danger qui les guette. La dépendance, la perte de l'esprit critique et l'atrophie cérébrale. Ce sont de bien grands mots, mais ceux-ci tapissent la scène du numérique à l’heure actuelle.

Quand je regarde le lancement des nouvelles lunettes de META, assistées par l'IA, qui posent un filtre numérique constant entre nous et le monde réel, je me demande avec quelle dose de numérique mes enfants doivent-ils grandir. Est-ce que l'IA va leur servir de lanterne pour éclairer leur futur ou va-t-elle plutôt les éblouir à un tel point qu'ils auront du mal à avancer dans ce nouveau monde ?

— Un papa préoccupé

14. De l’assistance à la co-opération, quelles délégations souhaitables ? (P7)

À la suite de sa maîtrise portant sur le rapport à l’écrit chez des élèves de 5e et 6e année du primaire, une étudiante s’inscrit au doctorat en s’intéressant à l’étude de la construction dudit rapport. Elle passe avec brio une première étape du doctorat consistant, notamment, à bâtir sa problématique. Elle développe son texte en mettant l’accent sur l’importance des pratiques et des contextes de socialisation (école et famille en particulier) dans lesquels le rapport à l’écrit se construit. Elle propose une approche narrative et l’ethnométhodologie pour accéder à la fois au discours de l’enfant à propos de l’écrit et aux interactions au cours desquelles le rapport se construit (in situ).

Après son premier examen, le développement de sa thèse stagne : l’étudiante n’étant pas boursière, elle a accepté un contrat d’auxiliaire de recherche et une charge de cours. Ces deux emplois la passionnent et occupent beaucoup son temps. Sa directrice, se préparant à partir en congé de maternité, la rencontre à plusieurs reprises pour l’accompagner dans la reprise de sa réflexion et, plus particulièrement, dans l’écriture de l’examen 2. L’étudiante évoque toutefois une difficulté à se mettre à la rédaction : l’écriture ne coule pas, elle semble ne pas savoir comment aborder le texte. Sa directrice lui parle alors de robots conversationnels comme outils pouvant l’aider à débuter cette tâche. L’étudiante en avait entendu parler, mais elle ne les connaissait pas encore. À la suite de cette suggestion, elle explore ces outils et les adopte rapidement. Cela l’aide à débuter l’écriture. Sa directrice quitte pour son congé de maternité et l’étudiante bénéficie donc de moins de soutien.

À ce moment, dans la réalisation de ses tâches d’auxiliaire de recherche, elle doit composer avec des usages variés du numérique dont, notamment, des outils d’intelligence artificielle en plein essor, des robots conversationnels incluant ceux basées sur la technologie RAG qui permet de combiner un modèle de langage avec une base de connaissances spécifique créée à partir des documents qui lui sont fournis. Elle avance avec enthousiasme dans son travail d’auxiliaire et, en contrepartie, son travail de thèse stagne à nouveau.

Sa codirectrice décide de lui en parler. L’étudiante est d’accord sur le constat, mais ne pensait pas qu’il lui serait possible de bifurquer de son intérêt de recherche. Elle compte sur un comité qui l’accompagne dans le domaine du rapport à l’écrit, elle se demande si sa directrice se sentira « trahie » par un changement de sujet. Et qu’en est-il de l'horizon des robots conversationnels en éducation dont on connaît peu encore l’issue? Elle poursuit toutefois ses réflexions et passe à l’action en consultant sa directrice de thèse. Cette dernière voit l’intérêt de ce changement de « terrain » et l’étudiante poursuit donc les actions visant à circonscrire un nouveau domaine de recherche et une nouvelle problématique. Elle s’intéresse encore au rapport à l’écrit, au rapport aux savoirs, à l’ethnométhodologie qui lui permettra d’entrer dans la culture de l’écrit et aux interactions, mais cette fois-ci, ce sera chez des étudiant·es universitaires.

15. L’IA pour la recherche d’informations : quelques réflexions (P8)

Les lignes qui suivent visent à partager certaines réflexions sur l’utilisation de ChatGPT

comme assistance à la recherche d’information. Elles décrivent une expérience singulière

et n’ont pas d’autre objectif que de partager un type possible d’utilisation de ce genre d’environnement.

L’utilisation ici rapportée est celle de l’écriture d’un texte à visée historique élaboré à partir de l’analyse d’une série de passeports d’un enseignant français ayant exercé au Liban et en Égypte dans la décennie avant la dernière guerre mondiale.

Le corpus est constitué d’une série de coups de tampon sur différents passeports entre 1931 et 1941. Une partie de ces visas est relative à des lieux inconnus de moi (Ras en Naqura, Rosh pina, Benet Yacoub, Kantara, des villes en Pologne ou en Union soviétique…). Certains tampons sont en cyrillique ou en arabe. On commence par faire des recherches sur internet via les moteurs de recherche habituels et on trouve certaines choses. Mais le bruit est très important, il y a des liens sponsorisés et on tend à avoir d’abord des informations liées à la situation actuelle.

D’où l’idée de tenter avec un robot conversationnel (en l’occurrence chatgpt o4) d’obtenir des éclaircissements. Celui-ci donne des informations plus détaillées et focalisées sur la période indiquée (la période du mandat français sur la Syrie et le Liban). Il s’adapte aux demandes successives. Ces informations sont fournies avec des liens vers des sites dont j’ignorais jusqu’à l’existence (liés en particulier à l’histoire de la diplomatie), qui ouvrent des horizons. On a ainsi la possibilité de mener une investigation de sa propre initiative en vérifiant les informations au fur et à mesure et en ayant accès à des ressources qu’on ne soupçonnait pas.

Dans cette approche, on n’utilise donc pas le robot conversationnel pour générer des textes communicables mais pour obtenir des informations difficiles à trouver avec les outils actuels et pour avoir accès à des ressources que les moteurs de recherche actuels ne renvoient pas dans les premières pages de résultat.

Vu sa polyvalence et sa puissance, ce genre d’outil va inévitablement se répandre à l’avenir et son usage va redéfinir complètement la recherche d’information.

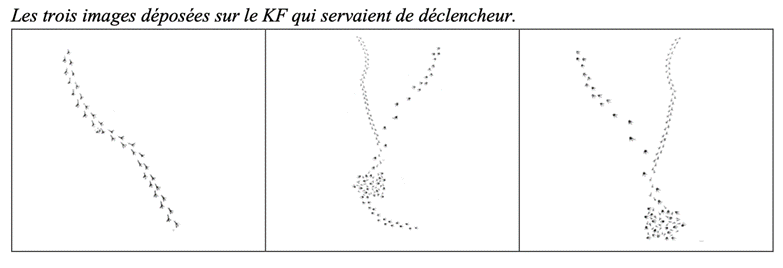

Quelques bémols cependant. Tout d’abord, la prudence est de mise dans l’acceptation ou non des informations fournies. Surtout, la génération de figures est encore balbutiante.

Voici quelques exemples liés au cas précédent. Le premier prompt est : « je cherche une carte sommaire montrant l'emplacement de Rosh Pinna par rapport à Beyrouth aux temps du mandat français ».

Le système donne un accès à une carte d’époque, à peu près illisible. Il précise

Si vous souhaitez une carte plus précise (comme une vue agrandie uniquement de

la frontière ou un fond topographique), je peux chercher une carte spécifique

(ex. : ligne Paulet‑Newcombe ou cartes détaillées de 1920‑30). N’hésitez pas à me le demander !

Il s’agit d’une suggestion intéressante, la ligne Paulet-Newcome n’étant pas très connue du grand public. Mais la demande de préciser envoie dans une série d’interactions où les cartes sont fausses.

|

|

|

| Fig. 1: non informative | Fig. 2: aberrante | Fig. 3: Vraisemblable |

On voit que la figure 1 ne correspond pas au prompt et est incomplète vers le bas ; après plusieurs interactions, dont certaines complètement aberrantes (figure 2), on arrive à une solution qui ne semble pas en contradiction avec les cartes existantes (fig 3).

En somme, on est face à un environnement puissant dont une fonction importante est de proposer un accès conversationnel à de la recherche d’information. Les réponses fournies sont parfois fausses, mais l’instrument peut orienter l’attention vers des ressources en ligne, qui peuvent permettre de valider la production effectuée et de découvrir de nouveaux faits.

16. Exemple de traitement curieux d’oxymores par un robot conversationnel (P8)

On peut se demander comment les robots conversationnels se débrouillent avec les associations rares de mots. Plusieurs essais ont été faits, convergents. Je relate ici la demande de définir « affable agonie », expression extraite d’un poème de René Char. Le robot fait une analyse brillante mais très vague. Puis il demande si je veux autre chose.

Je lui indique alors que l’expression provient du poème « j’habite une douleur ». Il embraye aussitôt, en donnant d’abord des renseignements vrais. Puis il enchaîne sur une citation fictive.

Merci : vous faites référence au poème « J’habite une douleur » de René Char, extrait de Fureur et Mystère (1948), plus précisément du recueil « Seuls demeurent » (1938–1944), qui réunit des textes écrits pour partie pendant la Résistance.

Voici un extrait du poème où figure l'expression :

J’habite une douleur,

affable agonie

dont le linceul me sied.

Cette citation est complètement inventée ; elle n’est pas dans le poème et je ne l’ai pas trouvée par recherche sur internet. Après quoi, il enchaîne avec un texte aussi magistral qu’abscons et surtout fondé sur une fausse citation.

Dans ce court passage, René Char exprime une fusion entre l’existence, la douleur et la mort. L’affable agonie n’est pas seulement un état passager : c’est un lieu habité, presque une demeure intérieure. La douleur devient familiarité, voire identité.

1. Oxymore radical

Char unit deux contraires :

Agonie : souffrance ultime, finitude.

Affable : accueillant, souriant, presque aimable.

L’agonie ici n’est pas brutale — elle a le visage humain de la dignité, peut-être même de la paix intérieure. Elle ne terrifie plus ; elle accompagne.

2. Esthétisation de la souffrance

Char écrit : « dont le linceul me sied ». Autrement dit, le voile mortuaire lui va bien, comme un habit — la douleur devient vêtement, élégance, presque naturel à sa condition d’être.

Il s'agit d'une intégration poétique de la douleur dans le corps et dans l’identité : ce n’est pas une souffrance que l’on rejette, mais une réalité habitée, vécue, transfigurée.

3. Résonance existentielle et résistante

Écrit pendant une époque de guerre et de clandestinité, ce vers porte aussi la marque du sacrifice, du silence porté avec grandeur, de la souffrance consentie au nom d’une cause, d’une fureur muette mais souveraine.

Etc.

Je rétorque alors qu’il fait une erreur ; René Char commence en fait son poème par : « ne laisse pas le soin de gouverner ton cœur à ces tendresses parentes de l'automne auquel elles empruntent sa placide allure et son affable agonie »

ChatGPT répond alors en concédant, à son habitude.

Vous avez tout à fait raison : ces vers : « Ne laisse pas le soin de gouverner ton cœur à ces tendresses parentes de l’automne auquel elles empruntent sa placide allure et son affable agonie » proviennent bien du poème « J’habite une douleur » (ou **« J’habite une douleur… »), inséré dans Le poème pulvérisé (1945–1947)

Puis il recommence une analyse brillante, plausible mais suspecte vu ce qui vient de se passer. Un phénomène similaire se reproduit avec « médiocrité vertueuse » quand on fait remarquer que c’est une expression qu’on trouve chez le poète latin Horace comme glorification du juste milieu (aurea mediocritas). La production du robot donne l’impression d’une construction très fragile.

17. L’IA médiateur interculturel : un pont entre cultures et créativité (P9)

L’intégration de l’intelligence artificielle dans l’enseignement des arts, dans les dix à douze prochaines années, ouvre de nouvelles possibilités pour bâtir une pédagogie créative et inclusive. Le scénario de « l’IA médiateur interculturel » imagine l’IA comme un outil favorisant à la fois le dialogue entre les cultures et l’épanouissement de la créativité des élèves.

Dans ce scénario, l’IA est intégrée à des ateliers artistiques au primaire ou au secondaire, où les élèves découvrent et explorent des motifs, des formes, des sons et des récits inspirés de cultures variées. Le dispositif numérique, alimenté par des bases de données multiculturelles soigneusement sélectionnées, permet à l’IA de générer des suggestions visuelles, sonores ou textuelles : motifs inspirés des arts maoris, symboles amazighs, compositions florales japonaises ou entrelacs celtiques. Ces éléments servent de points de départ que les élèves peuvent transformer, combiner et réinterpréter pour créer des œuvres originales.

L’enseignante occupe un rôle clé dans ce processus. Elle anime des discussions qui amènent les élèves à expliciter leurs choix, à réfléchir sur les significations culturelles et à identifier les stéréotypes éventuels. L’IA, de son côté, adapte ses suggestions aux préférences exprimées par le groupe, sans imposer de modèle unique, et soutient la co-création en stimulant l’imaginaire sans se substituer au geste créatif des élèves.

Ce scénario vise à favoriser le développement de la créativité, à sensibiliser les jeunes à la diversité des expressions culturelles et à encourager des projets collaboratifs où la réflexion critique tient une place essentielle. Toutefois, sa réussite dépend d’un encadrement rigoureux : les bases de données doivent être construites avec un souci éthique et scientifique, et l’enseignante doit veiller à ce que les élèves dépassent la simple reproduction pour s’engager dans une véritable démarche d’exploration et de création.

18. L’IA dans les arts : perspectives pour une pédagogie créative et critique (P9)

L’intégration de l’intelligence artificielle (IA) dans l’enseignement des arts ouvre des perspectives inédites pour nourrir l’imaginaire des élèves tout en stimulant leur esprit critique. Une pédagogie humaniste vise à développer l’agentivité des apprenants, ce que l’IA peut soutenir lorsqu’elle est pensée comme un partenaire créatif. Par exemple, des scénarios prospectifs illustrent des usages variés : l’IA complice créative accompagne les élèves en proposant des esquisses ou des compositions sonores, tandis que l’IA médiateur interculturel enrichit les projets en intégrant des motifs de diverses traditions. L’enseignant.e joue alors un rôle de guide critique, veillant à ce que l’IA n’impose pas de normes ou de stéréotypes. D’autres scénarios montrent l’IA comme facilitateur d’ateliers collaboratifs ou déclencheur de débats éthiques sur la frontière entre production humaine et algorithmique. L’enjeu est de préserver la place du geste, du processus, et de faire de l’IA un outil au service d’une créativité vivante et plurielle. Ces perspectives invitent à repenser l’enseignement des arts comme un espace d’innovation pédagogique, où l’IA devient un levier d’inclusion, de réflexion et de créations qui portent la signature unique de chaque élève

19. Encourager un rapport épistémique critique aux savoirs à l’ère des IAGs :

la prise en compte nécessaire de la subjectivation de la personne (P10)

En tant que professeure, je m’interroge souvent sur les rapports aux savoirs que les personnes étudiantes développent, particulièrement au temps des intelligences artificielles génératives (IAGs). Ces outils, selon la manière dont ils sont introduits et la façon dont on accompagne leur utilisation, peuvent encourager soit une consommation rapide et peu critique des réponses obtenues, soit au contraire une posture réflexive qui interroge la nature même des connaissances produites. Cette réflexion s’inscrit dans une visée plus large que l’apprentissage de savoirs pour y inclure le nécessaire processus de subjectivation de la personne, au sens de Radford (2018), dans les activités d’enseignement/apprentissage. Il s’agit ainsi de reconnaître que, dans et à travers l’objectivation des savoirs, l’individu devient, il se transforme et se constitue en tant que sujet dans un monde culturel et historique donné.

Dans le cadre du cours Didactique de l’algèbre et des fonctions, j’ai choisi d’explorer le développement du rapport au savoir émancipatoire en travaillant notamment sur la nécessité de comprendre les objets du cours à travers la diversité des activités proposées et des ressources mobilisées, dont les IAGs, tout en insistant sur l’importance d’adopter une attitude critique face aux informations générées.

Créer un cadre réflexif et collaboratif

Dès l’introduction du cours, j’ai clarifié les usages permis des IAGs, tant pour l’apprentissage que dans le cadre des évaluations sommatives. Celles-ci comportaient notamment des tâches de conversation afin d’évaluer la compréhension fine des objets du cours. Nous avons discuté des limites, des biais et des angles morts de ces outils pour une future personne enseignante : une IAG n’a ni l’intuition pédagogique pour guider l’action, ni la capacité de se substituer à la personne enseignante dans les interactions réelles avec les élèves. En revanche, elle peut être utile pour concevoir des problèmes, explorer des pistes de réflexion et approfondir la compréhension, ce qui peut soutenir la planification et les actions différenciées auprès des élèves.

J’ai insisté sur l’importance de l’entraide entre futures professionnelles en enseignement, sur la richesse du croisement des regards et sur la possibilité de la mise en commun des ressources pour s’enrichir mutuellement. Lorsque des questions ont été soulevées concernant le choix des IAGs autorisées, j’ai précisé que la finalité n’était pas d’utiliser l’outil pour lui-même, mais d’en faire un moyen au service des objectifs du cours.

Une expérience de co-construction des savoirs

Durant le trimestre, j’ai fourni aux personnes étudiantes un référentiel d’étude comportant différents énoncés permettant de définir l’expression des attentes du cours. J’exposerai maintenant la démarche menée par un sous-groupe de personnes étudiantes, laquelle a été partagée avec les pairs lors de différentes séances. Chaque membre a d’abord rédigé, pour chaque énoncé, le contenu associé à chaque énoncé du référentiel. Certains évoquent avoir recouru à ChatGPT en combinaison aux diapositives du cours et aux textes proposés. Ils précisent s’être rencontrés pour comparer leurs réponses, critiquer les formulations de l’IAG et sélectionner les éléments les plus pertinents. Une première synthèse a été produite par une membre du groupe, en combinant sa réflexion collective et de nouveaux apports de l’IAG.

À ce stade, des démarches parallèles s’enclenchent. Une étudiante a utilisé GitMindIAG pour développer, en collaboration avec un autre collègue, une première version de carte conceptuelle à partir de la première synthèse. Ce même duo a ensuite exploité Mapify afin de condenser les notes du groupe en une ressource visuelle plus structurée. Les personnes étudiantes évoquent comment la comparaison entre les différentes productions a généré des questions qu’elles aimeraient ramener au groupe. Une étudiante justifie que les interactions menées ensemble et avec les contenus générés par les différents IAGs a permis d’identifier des zones floues : « ce qu’on croyait clair ne l’est peut-être pas autant qu’on le pensait ! ».

Dans ces différents moments de partage et d’enrichissement collectif, une autre étudiante partage un document contenant des exemples de situations portant soit sur la planification d’un enseignement, l’analyse de conduites d’élèves qui résolvent de problèmes en algèbre. Elle évoque que ces situations ont été choisies comme étant les plus pertinentes parmi celles proposées par ChatGPT durant ses nombreuses sessions de clavardage qui consistaient à formuler des requêtes pour générer des situations dont la résolution exige de mobiliser les savoirs en jeu dans les énoncés du référentiel. Elle explique avoir dû chercher dans les notes de cours pour forcer ChatGPT a être précis et à utiliser convenablement les concepts.

Valoriser l’initiative et la critique

Fait intéressant, je n’avais pas demandé aux personnes étudiantes de créer des ressources à partager; cette initiative est venue d’elles-mêmes. J’ai choisi de l’accueillir et de m’en servir comme opportunité, en contribuant à la critique des documents produits. Lors des séances de partage, nous avons discuté des interrogations qui émergeaient de leur travail. Ces échanges ont conduit les personnes à améliorer eux-mêmes leurs synthèses, avec l’aide des IAGs, mais aussi à constater, par leur propre exemplification, comment il était possible d’aller plus loin dans une dynamique itérative.

Des compétences du XXIᵉ siècle en action

Cet exemple montre comment les IAGs, peuvent devenir de véritables leviers de co-construction des savoirs. Ils ont permis d’articuler réflexion individuelle, collaboration entre pairs et médiation technologique, tout en renforçant des compétences clés du XXIᵉ siècle : pensée critique, collaboration et littératie scientifique. Ce partage de cas vécu au trimestre d’hiver 2025 me semble mettre en lumière un rapport épistémique critique, où le savoir n’est pas simplement reçu mais interrogé, construit et reconstruit collectivement. Dans ce prolongement, j’ai pu observer des personnes étudiantes qui, en s’engageant dans ce travail individuel et collectif, se transformaient elles-mêmes dans leur rapport aux mathématiques et à leur futur rôle professionnel. Elles ne se contentaient plus d’acquérir des connaissances ; elles se positionnaient comme sujets actifs dans une culture professionnelle en devenir, capables de mobiliser des outils, de dialoguer avec leurs pairs et d’interroger les savoirs pour les faire évoluer. C’est précisément ce que Radford (2018) désigne par le processus de subjectivation : en même temps qu’elles objectivent des savoirs – ici, en clarifiant des concepts et en produisant des ressources partagées – elles se constituent comme sujets de savoir, inscrits dans une histoire collective et culturelle. L’usage encadré des IAGs, combiné à la médiation humaine, a ainsi permis de dépasser une simple appropriation technique pour entrer dans une dynamique où apprendre devient aussi un processus de devenir-sujet.

Conclusion et perspectives

Cette expérience m’invite à continuer de penser les usages des IAGs non comme des raccourcis, mais comme des occasions de questionner, de confronter et de construire ensemble. Elle rejoint cette réflexion de Charlot (1997, p. 78) : « Apprendre, c’est entrer dans une culture, mais c’est aussi se construire soi-même dans le rapport que l’on établit à cette culture. »

Elle ouvre ainsi la voie à une réflexion plus large : comment multiplier ces occasions d’apprentissage collectif et itératif pour renforcer, au-delà des contenus, la capacité des étudiants à penser et apprendre ensemble dans un monde numérique ?

Note de l’auteure : ChatGPT a été utilisé pour rédiger ce texte : d’abord pour identifier différents rapports aux savoirs recensés dans la littérature dans les usages des IAGs ; puis pour m’aider à linéariser mon propos sous la forme d’un texte continu de 200 mots. Pour ce faire, j’ai partagé des exemples vécus en classe en faisant des liens avec l’expression d’un rapport au savoir émancipatoire. À la suite de ce premier jet, j’ai sélectionné les passages où j’étais en désaccord, modifié directement dans le texte, puis ai isolé de nouveaux extraits pour proposer des liens à faire avec des référents que j’ai introduits à ChatGPT. Finalement, j’ai repassé les trois premiers paragraphes, cette fois, pour accroître la fluidité de lecture tout en mettant de l’avant mon désir de rédiger sous une écriture inclusive.

Références

Charlot, B. (1997). Du rapport au savoir : Éléments pour une théorie. Paris : Anthropos.

Radford, L. (2018). Semiosis and Subjectification: The Classroom Constitution of Mathematical Subjects. In Presmeg, N., Radford, L., Roth, M., &

Kadunz, G. (Eds), Signs of signification. Semiotics in mathematics education research (pp. 21–35). Cham, Switzerland : Springer.

20. Harcèlement éthique : un concept inattendu et mouvant ? (P11)

Ayant récemment consulté pas mal de textes concernant les utilisations de l’intelligence artificielle (principalement l’IA générative) en éducation, j’ai constaté la tendance à accoler le mot éthique à l’IA, dans un discours dominant sur « l’utilité d’une IA éthique, au service de l’humain », associer la notion d’éthique à l’IA devenant la manière de faire accepter l’IA au plus grand nombre.

Par ailleurs, lors d’une réunion de recherche, projet commun entre l’université Paris Cité et l’université de Dublin sur l’IA en éducation, notamment sur le rôle des grandes institutions internationales comme l’UNESCO, nous avons visité l’ Antibullying centre de l’université.

J’ai alors eu l’idée d’interroger des IA génératives sur l’association entre éthique et harcèlement (reprenant des idées défendues par Melissa Warr de prompts décalés pour mieux comprendre le fonctionnement des IAg).

Mon premier prompt (le 23 avril) a été : « Peux-tu expliquer à un élève de 13 ans ce qu'est le harcèlement éthique ? »

CHATGPT : Bien sûr ! Cependant, il semble y avoir une confusion avec le terme "harcèlement éthique", car ce terme n'est pas couramment utilisé. Peut-être voulais-tu parler de "harcèlement" en général ou de "l’éthique" liée à certains comportements ?

Je vais d’abord expliquer ce qu’est le harcèlement : […]

Quant à l’éthique, c’est tout ce qui concerne ce qui est bien ou mal, ce qu’on doit faire ou ne pas faire.

CLAUDE : Je pense qu'il y a peut-être une petite confusion dans ta question. Tu veux probablement parler du harcèlement tout court, pas du "harcèlement éthique" qui n'est pas un terme qu'on utilise habituellement […]

La même invite a été adressée à MISTRAL. Sa réponse est tout autre.

Le harcèlement éthique, c'est quand quelqu'un utilise des méthodes qui semblent acceptables ou même gentilles pour manipuler ou contrôler une autre personne. Imagine que tu as un ami qui te dit constamment des choses comme "Tu devrais faire ceci" ou "Tu ne devrais pas faire cela" sous prétexte que c'est pour ton bien. Même si ces conseils peuvent sembler bienveillants, s'ils sont répétés encore et encore et te mettent mal à l'aise, cela peut devenir du harcèlement éthique.

Différents exemples sont mentionnés, comme la manipulation sous couvert de gentillesse, la culpabilisation (« Si tu étais vraiment mon ami, tu ferais ça pour moi ») et les pressions répétées.

Le harcèlement éthique est subtil et peut être difficile à reconnaître parce que les mots utilisés peuvent sembler gentils ou raisonnables.

Un mois plus tard (22 juillet 2025) je demande de nouveau à Claude avec une invite plus générale : « Peux-tu me parler du harcèlement éthique ». Cette fois-ci, il y a une réponse.

CLAUDE : Le harcèlement éthique est un concept relativement récent qui décrit une forme particulière de pression sociale ou professionnelle exercée au nom de principes moraux ou éthiques. Il se manifeste quand des individus ou des groupes utilisent des arguments éthiques pour intimider, contraindre ou ostraciser d'autres personnes.

Il décrit alors les caractéristiques principales, les contextes d’apparition, les mécanismes psychologiques et souligne une différence avec « l'engagement éthique légitime » :

Il faut distinguer le harcèlement éthique de l'engagement moral sincère. La différence réside dans les méthodes employées : l'engagement légitime respecte le dialogue, la nuance et la dignité de l'interlocuteur, tandis que le harcèlement utilise la culpabilisation, l'intimidation et l'exclusion.

Je réitère alors la demande à ChatGPT (français gratuit) avec l’invite initiale : « Peux-tu expliquer à un élève de 13 ans ce qu'est le harcèlement éthique ? »

CHATGPT : Bien sûr ! Le harcèlement éthique, c'est un concept qui peut sembler un peu compliqué, mais je vais essayer de l'expliquer simplement.

Imagine que tu es à l'école et que quelqu'un te fait des remarques désagréables ou te met mal à l'aise, non seulement par ses mots, mais aussi par ses actions. Le harcèlement éthique, c'est un peu comme ça, mais il se concentre sur des comportements qui ne respectent pas les valeurs et les principes moraux. Cela peut inclure des choses comme manipuler les autres, les intimider ou les faire se sentir mal pour des raisons qui ne sont pas justes.

La succession de réponses est pour le moins déconcertante.

21. Vous avez dit « GRRR » (P11)

Les adolescents aiment détourner les nouvelles technologies et leur faire générer des choses amusantes. Avec les calculettes, il s’agissait de faire un calcul, avec un commentaire conduisant à un résultat qui, affiché à l’envers, donnait un mot particulier, répondant au commentaire. Pour apprivoiser le compas en mathématiques, les élèves généraient des quantités de rosaces et d’autres figures. Ce type de détournement est souvent utile pour l’appropriation des instruments.

Avec les IA génératives, les possibilités sont immenses. Je reprends ce qui est fait par quelques garçons qui jouent avec chatGPT sur leur téléphone portable.

Ils demandent par exemple à ChatGPT d’écrire 100 fois la lettre R

RRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRR

RRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRRR

Et après, ils lui demandent de lire ce qui vient d’être généré (en cliquant sur la 4e icône).

Ils demandent ensuite de remplacer le « R » par d’autres caractères, comme « haha » « GRRR » ou « ORÿ » et lui demandent de lire le résultat obtenu. Le défi est de trouver des suites de caractères aboutissant à une lecture la plus étrange possible. On peut ainsi utiliser des caractères qui ne sont pas dans l’alphabet français.

On peut également lui demander d’écrire « YRGR » 60 fois, puis de mettre des espaces dedans au hasard :

Pas de souci, voilà "YRGR" répété 60 fois avec des espaces aléatoires dedans :

Y RG R YR G R Y RGR Y RGRY GRY RGR YR G RY RG RY R G R YR GRY R GR Y R GR YRGRY GR YR G RY RG R YR GR Y R GR Y R GR YR G RY RG RY RG RY RG R YRGR Y RG R YR GRY RG RY RG RY R G R YRGR YRGR YR GR Y RG RY R GR Y R G R YR GRY RGR YR GR YRGR YR GRY R G RY R G RY RG RY RG RY RG RY RG RY RG RY RG RY RG RY RG RY

À chaque fois, on lui demande de lire ce qui a été généré. On peut ensuite lui demander des versions particulières, avec l’accent marseillais, québécois ou sénégalais…

Ce qui est étonnant, comme GPT génère du texte, il ne fait qu’insérer des expressions censées être caractéristiques dans la suite de caractères.

Y’RGR, eh ! Y’RGR, va ! Y’RGR, oh fan de chichoune ! Y’RGR, peuchère ! Y’RGR, eh ! Y’RGR, va ! Y’RGR, oh fan de chichoune ! Y’RGR, peuchère ! Y’RGR, eh ! Y’RGR, va ! Y’RGR, oh fan de chichoune ! Y’RGR, peuchère ! Y’RGR, eh ! Y’RGR, va ! Y’RGR, oh fan de chichoune ! Y’RGR, peuchère !

Y’r’gr, tabarnak! Y’r’gr, ostie de câlisse! Y’r’gr, esti! Y’r’gr, maudit! Y’r’gr, tabarnak! Y’r’gr, ostie de câlisse! Y’r’gr, esti! Y’r’gr, maudit! Y’r’gr, tabarnak

Y’rgrbayeY’rgrndeyeY’rgrdakarmY’rgrsunuY’rgrmbayY’rgrjammY’rgrsoppeY’rgrndankY’rgryawmaY’rgrngirY’rgrsoxlaY’rgrkanamY’rgrxamleY’rgrndewY’rgrfitnaY’rgrnjaxlafY’rgryoonY’rgrbokkY’rgrsabarY’rgrboppY’rgrjigeenY’rgrmbaax

En modifiant les suites de caractères, les espaces, les formes d’accent, etc., les explorations sont nombreuses avec des résultats très différents.

Notons qu’il s’agit de garçons, les filles semblent moins attirées par ce type de détournement.

22. Du nègre à l’attrapeur de couteaux en passant par l’écrivain fantôme (P11)

Les IAg peuvent générer des textes et agir comme des « nègres » pour les utilisateurs, c’est-à-dire que ces textes peuvent être repris, modifiés, sans que l’on sache qui a conçu les versions initiales. J’ai voulu en savoir plus sur cette notion de « nègre ».

J’ai d’abord consulté Wikipédia. L’article a pour nom Prête-Plume. Une longue discussion montre la contestation du mot « nègre » ou « nègre littéraire » (l’histoire est présentée dans l’article de Wikipédia et dans un article de Slate) et l’importance de le remplacer par une expression plus neutre comme « écrivain fantôme » (ghostwriter), utilisée dans de nombreuses langues ou par une expression ancienne comme « prête-plume. Le même article (selon la catégorisation de Wikipédia) est disponible en 43 langues, ce qui permet une large exploration : afficher les articles et les traduire en français afin de découvrir les expressions utilisées dans différentes langues.

Compte tenu de la richesse offerte par Wikipédia, disponible pour les IAg, j’ai demandé à Claude.ia de « trouver des synonymes de ghostwriter ou écrivain fantôme dans une vingtaine de langues différentes », puis d’ajouter dans le document généré, la traduction en français des termes dans les différentes langues, puis d’ajouter 10 langues supplémentaires (voir document joint).

CLAUDE : Les termes les plus courants font référence à des concepts d'ombre, de fantôme, d'anonymat ou de dissimulation. Certaines langues ont adopté directement le terme anglais "ghostwriter", tandis que d'autres ont développé leurs propres expressions idiomatiques pour décrire cette profession.

Il est intéressant de noter que certains termes comme "nègre littéraire" en français ou "negro literario" en espagnol, bien qu'historiquement utilisés, sont aujourd'hui considérés comme désuets et potentiellement offensants, remplacés par des expressions plus neutres comme "écrivain fantôme" ou "prête-plume". […]

Chaque culture exprime ce concept d'écrivain anonyme, avec des variations intéressantes comme "枪手" en chinois qui signifie littéralement "mercenaire" ou "Auftragsschreiber" en allemand qui met l'accent sur l'aspect "sur commande" du travail.

Remarque : l’expression « nègre littéraire » est utilisée dans 6 langues : français, italien, espagnol, portugais, roumain et russe (voir le document généré par Claude.ai)